言語モデルの選択

miiboで利用可能な言語モデルを紹介します

言語モデルの選択

miiboでは、エージェントの応答に使用する大規模言語モデル(LLM)を自由に選択できます。 言語モデルは、実用されるAIの「知能」レイヤーとなる重要な要素で、選択したモデルによって応答の品質やコストが大きく変わります。

利用可能な言語モデル一覧

miiboでは50種類以上の言語モデルから選択可能です。各モデルの特徴は以下の通りです:

消費ポイント:1回の応答で消費されるポイント数

個別APIキー:自身のAPIキーを設定できるかどうか

言語モデル | 提供元 | 消費ポイント | 個別APIキーの利用 |

|---|---|---|---|

GPT-5.2 | OpenAI | 22 | ✅ |

GPT-5.1 | OpenAI | 15 | ✅ |

GPT-5 | OpenAI | 15 | ✅ |

GPT-5 Mini | OpenAI | 9 | ✅ |

GPT-5 Nano | OpenAI | 3 | ✅ |

GPT-4 | OpenAI | 50 | ✅ |

GPT-4 turbo | OpenAI | 20 | ✅ |

GPT-4 Turbo Vision | OpenAI | 30 | ✅ |

GPT-4o | OpenAI | 15 | ✅ |

GPT-4o(Azure) | Microsoft | 15 | |

GPT-4o-mini | OpenAI | 5 | ✅ |

GPT-4o-search preview | OpenAI | 15 | ✅ |

GPT-4o-mini-search preview | OpenAI | 5 | ✅ |

GPT-4.1 | OpenAI | 10 | ✅ |

GPT-4.1 mini | OpenAI | 8 | ✅ |

GPT-4.1 nano | OpenAI | 3 | ✅ |

GPT-4.5-preview | OpenAI | 60 | ✅ |

GPT-3.5 turbo (Azure) | Microsoft | 5 | ✅ |

GPT-3.5 turbo 16k (Azure) | Microsoft | 30 | ✅ |

GPT-3.5 turbo 16k | OpenAI | 20 | ✅ |

GPT-3.5 turbo (ファインチューニング済み) | OpenAI | 5 | ✅(必須) |

o1 preview | OpenAI | 45 | ✅ |

o1 | OpenAI | 45 | ✅ |

o1 pro | OpenAI | 450 | ✅ |

o1 mini | OpenAI | 15 | ✅ |

o3 mini | OpenAI | 15 | ✅ |

o3 | OpenAI | 45 | ✅ |

o4 mini | OpenAI | 15 | ✅ |

Claude-3 Haiku | Anthropic | 10 | ✅ |

Claude 3.5 Haiku | Anthropic | 10 | ✅ |

Claude-3 Sonnet | Anthropic | 15 | ✅ |

Claude-3 Opus | Anthropic | 80 | ✅ |

Claude-3.5 Sonnet | Anthropic | 15 | ✅ |

Claude-3.7 Sonnet | Anthropic | 15 | ✅ |

Claude-4.0 Sonnet | Anthropic | 15 | ✅ |

Claude-4.0 Opus | Anthropic | 80 | ✅ |

Claude 4.1 Opus | Anthropic | 80 | ✅ |

Claude 4.5 Sonnet | Anthropic | 15 | ✅ |

Google PaLM2 | 5 | ||

Plamo 2 Prime | 10 | ✅ | |

Gemini Pro | 5 | ✅ | |

Gemini 1.5 Pro | 20 | ✅ | |

Gemini 1.5 Flash | 7 | ✅ | |

Gemini 1.5 Flash 8B | 4 | ✅ | |

Gemini 2.0 Flash | 4 | ✅ | |

Gemini 2.0 Flash Lite | 3 | ✅ | |

Gemini 2.5 Flash | 7 | ✅ | |

Gemini 2.5 Pro | 25 | ✅ | |

Gemini 2.5 Flash Lite | 3 | ✅ | |

Gemini 3 Pro | 30 | ✅ | |

Groq Llama 3 8B | Groq | 1 | ✅ |

Groq Llama 3 70B | Groq | 5 | ✅ |

Groq Mixtral 8x7B SMoE | Groq | 3 | ✅ |

Groq Gemma 7B | Groq | 1 | ✅ |

Groq LLaMA 3.1 405B | Groq | 15 | ✅ |

Groq Llama 3.1 8B | Groq | 1 | ✅ |

Groq Llama 3.1 70B | Groq | 5 | ✅ |

Groq Llama 3.3 70B Versatile | Groq | 4 | ✅ |

Groq Llama 4 Scout | Groq | 3 | ✅ |

Groq Llama 4 Maverick | Groq | 3 | ✅ |

Groq GPT OSS 20B | Groq | 3 | ✅ |

Groq GPT OSS 120B | Groq | 3 | ✅ |

Sakura Cotomi 2 Pro | Sakura | 45 | ✅ |

Sakura Cloud Qwen3-Coder-30B | Sakura Cloud | 3 | ✅ |

Sakura Cloud Qwen3-Coder-480B | Sakura Cloud | 4 | ✅ |

Sakura Cloud gpt-oss-120b | Sakura Cloud | 3 | ✅ |

Sakura Cloud llm-jp-3.1 | Sakura Cloud | 3 | ✅ |

消費ポイントについて

消費ポイントとは、AIが1回応答をする際に消費されるポイントです。 miiboでは、利用しているプランごとに会話上限ポイントが割り当てられています。 精度やコストに応じて消費ポイントが変わることにご注意ください。 ※個人のAPIキーを利用ができるAIは、APIキーを割り当てることで消費回数を一律1回にすることができます。

miiboの各プランの上限回数や料金は下記をご確認ください。

Reasoning Levelの指定

GPT-o1およびGPT-5モデルに対応した推論レベル(Reasoning Effort)の設定が可能です。エージェント設定でReasoning Levelを指定することで、AIの推論の深さを調整できます。「GPT-5」の応答が遅すぎてなかなか活用できない、といった場合は、「low」や「minimal」を指定いただくことで、よりレスポンスが高速なGPT-5を利用することができます。

設定可能な項目

- minimal

- low

- medium

- high

おすすめモデルと選び方

miiboが推奨する言語モデルとそれぞれの特徴をまとめます。

| 言語モデル | 精度 | レスポンス速度 | 費用(消費ポイント) | 補足 |

|---|---|---|---|---|

| GPT-4o | ◎ | ◯ | 15 | GPT-4匹敵の精度を持ち、コストも安価になったモデル。レスポンスも非常に早く、非常に実用的なモデル。画像の認識にも対応。 |

| GPT-4o-mini | ◯ | ◎ | 5 | GPT-4o小小型モデル型精度は若干劣るが、低コストで利用可能。 |

| GPT-4-turbo | ◎ | △ | 20 | GPT-4匹敵の精度を期待でき、コストパーフォーマンスも良い。現段階ではGPT-4の方が安定した挙動が多い。 |

| GPT-4 | ◎ | △ | 50 | プロンプトに記述した詳細な指示を柔軟に理解可能。コスト高。ハルシネーションを最も抑えるのに最適なモデル。 |

| GPT-3.5-turbo | △ | ◎ | 5 | GPT-4と比較すると大きく精度が落ちますが、圧倒的なコストの低さがメリットです。応答速度も非常に早いのも特徴です。プロンプトによる制御が効きづらいことが多いです。 |

| GPT-3.5-turbo 16k(プロンプト大) | △ | ◎ | 30 | GPT-4と比較すると大きく精度が落ちますが、圧倒的なコストの低さがメリットです。応答速度も非常に早いのも特徴です。プロンプトによる制御が効きづらいことが多いです。プロンプトを長く記述できるのが特徴です。 |

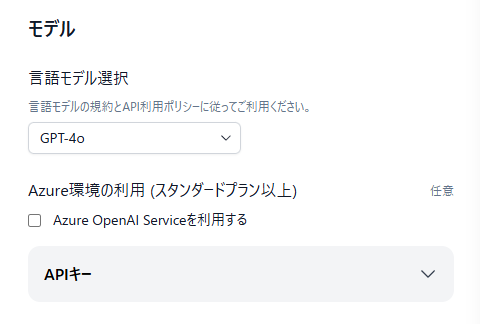

一部のモデルは、Azure OpenAI Serviceが提供するモデルを利用可能です。 下記の画面でチェックをすることで利用できます。

画像の認識が可能なモデルをする場合、画像のインプットはWebのチャット画面とAgentHubでのみ利用が可能です。 今後、その他のプラットフォームでも利用ができるようになる予定です。

Azure環境のモデルとOpenAI環境のモデルの違い

一部のモデルはAzure OpenAI Service上で動作します。 精度は基本的には変わらず、以下の点に差異があります。

・ 応答の安定性 Azure OpenAI Serviceが提供する環境はOpenAI環境より安定していると言われています ・ ストリーミング応答時の挙動の違い Azure OpenAI Serviceのストリーミング応答は、OpenAI社の提供するモデルのストリーミング応答と比べて、ストリーミングで送られてくる文字の塊が大きくなります。1文字ずつではなく、複数文字がまとめて返されます。そのため、OpenAI社提供のモデルよりも、ストリーミング応答の滑らかさに課題が出る場合があります。

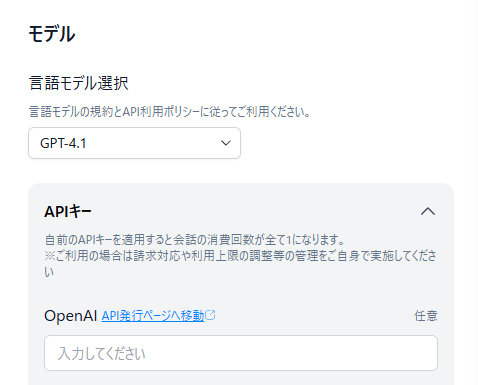

APIキーの個別設定

利用可能な言語モデル一覧で、個別APIキーの設定に✅がついているモデルは、ご自身のAPIキーを利用できます。

個別のAPIキーを利用する場合、会話ごとの消費ポイントは一律で「1」になります。尚、APIキーの取得や管理、APIキー発行元への決済などは、ご自身で実施頂く必要がございます。APIキーは、AIの応答および検索クエリー生成に利用されます。

※ 検索クエリー生成には一律でGPT-4oが利用されます。(2024年7月時点)

※ APIキーには利用状況に応じた優遇措置としてTierが設定されています。個別APIキーを設定した場合は初期段階からの開始となるため、応答のパフォーマンスが下がる可能性があります。詳細はOpenAI API Scale Tierをご参照ください。

Updated 3 days ago